Sommaire

Le Core Update de juin 2025 (30 juin – 17 juillet) se distingue comme l’une des refontes algorithmiques les plus profondes jamais documentées. L’analyse croisée des données Semrush, Sistrix, Similarweb et des observations terrain révèle un changement paradigmatique dans l’évaluation de la qualité par Google.

Magnitude algorithmique, quand les métriques s’affolent

L’ampleur de ce Core Update se mesure d’abord dans les données quantitatives. Les outils de surveillance de volatilité Google enregistrent des niveaux de fluctuation historiques qui témoignent d’une refonte algorithmique majeure.

Volatilité historique, les chiffres qui parlent

Les données Semrush établissent un record absolu : 16,1 % des URLs en top 10 post-update ne figuraient même pas dans le top 20 auparavant. Pour contextualiser cette anomalie statistique, ce taux représente une augmentation de 72,4 % par rapport au Core Update de mars 2025 et constitue le plus fort taux de renouvellement jamais mesuré en 4 ans de tracking algorithmique.

Similarweb confirme cette volatilité exceptionnelle via son SERP Seismometer, qui place cet update comme le plus instable depuis août 2024 et novembre 2023. Le pic de volatilité du 11 juillet atteint des niveaux comparables aux mises à jour historiques de Panda et Penguin dans leur amplitude de redistribution.

Cette volatilité ne suit pas les patterns habituels. Alors que les fluctuations top 3 restent dans les moyennes observées, l’instabilité explose dans les positions 4-10 et suggère une réévaluation algorithmique ciblée sur les contenus de « seconde zone » plutôt qu’une refonte globale des autorités établies.

Architecture en deux vagues, dissection temporelle

Au-delà de l’ampleur quantitative, l’architecture temporelle de ce déploiement révèle une sophistication technique inhabituelle.

L’analyse Sistrix via leur radar algorithmique identifie deux vagues distinctes d’impact, ce qui révèle une sophistication technique inhabituelle. Cette approche séquentielle suggère que Google a déployé des ajustements de sous-systèmes spécifiques durant le rollout, plutôt qu’une mise à jour monolithique.

Glenn Gabe documente précisément cette séquentialité : « Les poussées ont commencé les 8 et 9 juillet APRÈS le mouvement initial que nous avons vu avec le Core Update de juin. C’est un excellent exemple de Google mettant à jour un système spécifique, ou plusieurs, pendant le Core Update. »

Cette observation technique confirme l’hypothèse d’une activation progressive de classificateurs spécialisés, vraisemblablement liés aux systèmes d’évaluation de l’utilité du contenu intégrés depuis mars 2024.

Résurrection HCU(X), l’énigme des récupérations tardives

La caractéristique la plus remarquable de ce Core Update réside dans sa capacité à inverser des pénalisations historiques. Pour la première fois depuis septembre 2023, des sites décimés par le Helpful Content Update montrent des signes de récupération significative.

Mécanisme de récupération, analyse des patterns

L’événement le plus significatif de cet update reste la récupération partielle de sites décimés par le Helpful Content Update de septembre 2023. Gabe, qui maintient un corpus de tracking de 400 sites HCU(X), observe : « Les sites qui ont été anéantis par le Helpful Content Update (HCUX) de septembre 2023 ont enfin commencé à remonter. Et certains remontaient d’entre les morts (littéralement de retour sans aucune visibilité du tout). »

Ces récupérations ne démarrent qu’aux 8-9 juillet, soit 8-9 jours après l’initiation de l’update. Cette latence temporelle suggère l’activation différée d’un classificateur spécifique, potentiellement lié à la réévaluation des signaux de « helpfulness » intégrés au core ranking system.

L’hypothèse technique la plus plausible : Google a vraisemblablement ajusté les seuils de confiance du classificateur de contenu utile qui avait été intégré au système de ranking principal lors du Core Update de mars 2024. Cette recalibration pourrait expliquer pourquoi certains contenus précédemment sous-évalués retrouvent soudainement leur visibilité.

Corrélation MUVERA, vers l’évaluation granulaire

Cette récupération sélective trouve son explication technique dans l’évolution des systèmes d’évaluation de Google.

Marie Haynes établit une corrélation directe avec l’algorithme MUVERA qu’elle a analysé en détail : « Je crois que le Core Update de juin 2025 marque le début de changements significatifs dans la recherche où Google s’éloigne davantage de l’utilisation des signaux de classement traditionnels pour aller vers l’utilisation de l’IA pour identifier le contenu susceptible d’être utile. »

Cette hypothèse s’appuie sur les patterns observés dans son analyse des pages gagnantes. Les contenus qui dépassent la réponse évidente, démontrent une expertise de première main, et surtout, structurent l’information section par section pour faciliter l’extraction sémantique.

MUVERA permettrait à Google d’analyser le contenu de manière granulaire plutôt que holistique, ce qui explique pourquoi certains articles longs avec des sections utiles récupèrent tandis que des contenus globalement optimisés mais superficiels chutent.

Secteurs YMYL, cartographie de la volatilité algorithmique

Les secteurs sensibles révèlent des patterns particulièrement instructifs pour comprendre les nouveaux critères d’évaluation de Google. L’analyse sectorielle dévoile des traitements algorithmiques différenciés qui éclairent les priorités de la mise à jour.

Santé vs Finance, dichotomie révélatrice

L’analyse sectorielle révèle une dichotomie frappante dans l’impact YMYL. Similarweb documente que « l’industrie de la santé a connu une volatilité remarquablement élevée dans les cinq premières positions » tandis que « l’industrie financière a présenté des niveaux de fluctuation significativement faibles ».

Cette différence de traitement algorithmique s’explique par la nature des signaux E-E-A-T évalués. Le secteur santé, traditionnellement plus sensible aux signaux d’autorité médicale et de première expertise, subit une réévaluation plus agressive de ses contenus. Le secteur financier, déjà largement dominé par des institutions établies, présente moins d’opportunités de redistribution algorithmique.

Gabe observe que cette volatilité YMYL suit les patterns historiques mais avec une amplification significative : « Les sites contenant du contenu YMYL (Your Money or Your Life) peuvent toujours connaître beaucoup de volatilité lors des broad core updates, mais j’ai observé une tonne de volatilité avec le Core Update de juin. »

Implications NavBoost, signaux comportementaux amplifiés

Cette intensification sectorielle révèle l’importance croissante des signaux comportementaux dans l’évaluation algorithmique.

Cette hypothèse suggère une pondération vraisemblablement accrue des signaux NavBoost dans l’évaluation qualité. Ce système, qui agrège 13 mois de données d’interaction utilisateur, pourrait devenir particulièrement discriminant pour les contenus où la satisfaction utilisateur constitue un indicateur de fiabilité critique.

Cette hypothèse expliquerait pourquoi des sites YMYL avec une autorité topique forte mais une satisfaction utilisateur dégradée subissent des chutes importantes, tandis que des sites moins autoritaires mais avec des signaux d’engagement positifs progressent.

Impact AI Overviews, l’effet domino cross-surfaces

L’interconnexion entre le Core Update et les AI Overviews confirme l’architecture unifiée des systèmes de ranking Google. Cette corrélation technique démontre que l’analyse des brevets Google révèle comment AI Overviews transforme le SEO de manière intégrée.

Corrélation algorithmique, même core, même impact

L’analyse Semrush révèle un doublement spectaculaire du taux de déclenchement des AI Overviews : de ~10 % pré-update à 20 % au pic de déploiement (stabilisé à 15 % post-update). Cette corrélation directe confirme l’hypothèse technique que les AI Overviews puisent dans les mêmes systèmes de ranking que la recherche web classique.

Gabe valide empiriquement cette interconnexion : « Les sites impactés négativement par le Core Update de juin ont également vu leur visibilité dans les AI Overviews chuter. » Cette observation technique semble confirmer que les AI Overviews ne constituent pas un canal séparé mais une surface d’affichage alternative du même algorithme de pertinence.

Découplement sélectif, nuances sectorielles

L’évolution du comportement des AI Overviews révèle cependant des nuances importantes dans leur déploiement.

Contrairement à l’hypothèse d’un « Great Decoupling » généralisé, l’analyse terrain révèle des patterns sectoriels différenciés. Gabe documente des niches où « les AI Overviews ne se déclenchent pas souvent et les clics et impressions restent couplés (comme la plupart des sites avaient l’habitude de voir avant l’arrivée des AI Overviews) ».

Cette observation suggère que l’activation des AI Overviews suit une logique de pertinence sémantique : les requêtes informationnelles complexes déclenchent plus fréquemment les résumés IA, tandis que les requêtes transactionnelles ou ultra-spécialisées maintiennent l’affichage traditionnel.

Anomalies Search Console, symptômes d’une refonte technique majeure

Parallèlement aux bouleversements algorithmiques, une série de dysfonctionnements techniques dans Google Search Console révèle l’ampleur infrastructurelle de cette mise à jour. Ces anomalies, documentées méticuleusement par Scott Shorter, offrent un aperçu unique des impacts collatéraux d’un Core Update majeur.

Dysfonctionnements massifs, corrélation temporelle troublante

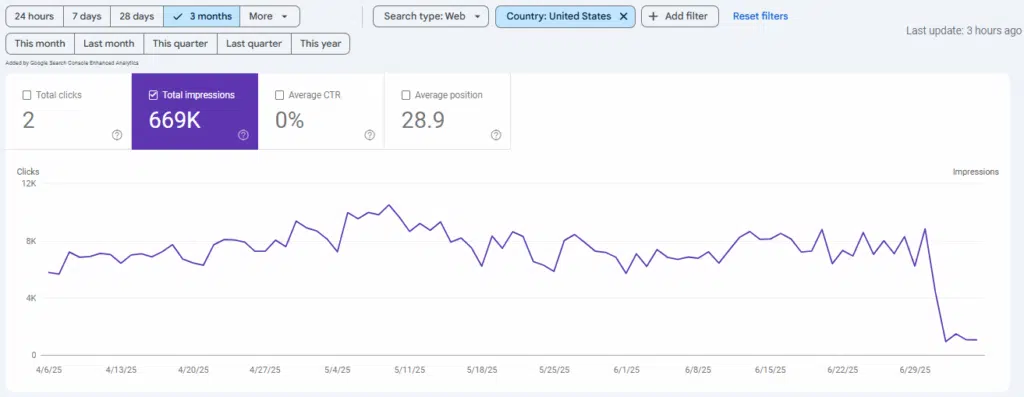

Parallèlement au Core Update, Scott Shorter documente une cascade d’anomalies techniques dans Google Search Console depuis le 30 juin, jour J du déploiement. Cette coïncidence temporelle dépasse la simple corrélation et suggère un impact infrastructurel de l’ampleur de la mise à jour.

Anomalie filtres pays : les sites .com.au voient leurs impressions exploser sous filtre Australie avec des chutes correspondantes sur les autres géographies. Les sites .co.uk répliquent ce pattern sous filtre UK. Point technique critique : les données non filtrées restent stables, ce qui confirme un bug de redistribution plutôt qu’un changement algorithmique réel.

Accumulation d’instabilités :

- 21 juillet : pic inexpliqué d’impressions sans filtre pays,

- 13-21 juillet : anomalie HTTPS avec creux puis rebond automatique,

- Fluctuations HTTPS multi-comptes simultanées.

Hypothèse technique : surcharge infrastructurelle

L’analyse de ces patterns techniques suggère une explication structurelle plutôt qu’algorithmique.

L’hypothèse la plus cohérente : ces dysfonctionnements multiples suggèrent une surcharge probable des systèmes de reporting causée par l’ampleur des recalculs algorithmiques. Le Core Update de juin a vraisemblablement déclenché un reprocessing massif des index, ce qui sature temporairement les pipelines de données Search Console.

Cette hypothèse s’appuie sur l’observation que les anomalies touchent les systèmes de filtrage et d’agrégation (pays, HTTPS) plutôt que les métriques brutes, pattern typique d’une saturation des systèmes de post-traitement des données.

E-commerce et marques, redistribution concurrentielle

L’analyse sectorielle de l’e-commerce révèle des mouvements particulièrement significatifs qui illustrent les nouvelles hiérarchies algorithmiques. Ces changements s’inscrivent dans l’évolution du SEO à l’ère de l’IA et transforment les équilibres concurrentiels établis.

Autorité vs spécialisation, nouvelle hiérarchie

Aleyda Solis observe une redistribution significative dans l’e-commerce avec un phénomène contre-intuitif : les marques gagnent sur leurs termes brandés grâce à « moins de packs shopping/carrousels affichés au-dessus de la première position », mais perdent sur les termes produits génériques au profit de « retailers majeurs/plus autoritaires ou petits mais hautement spécialisés/de niche ».

Cette redistribution révèle un ajustement algorithmique sophistiqué. Google privilégie désormais l’autorité généraliste ou l’hyper-spécialisation sur les termes produits, ce qui relègue les marques traditionnelles qui ne maîtrisent ni l’un ni l’autre positionnement.

Implications NavBoost retail, signaux comportementaux e-commerce

Cette évolution sectorielle confirme l’importance croissante des données comportementales dans l’e-commerce.

Cette évolution suggère une pondération accrue des signaux comportementaux e-commerce dans NavBoost. Les retailers généralistes bénéficient de patterns de navigation diversifiés, tandis que les spécialistes ultra-niche génèrent des signaux de satisfaction élevés sur leurs domaines d’expertise.

Les marques traditionnelles, prises entre ces deux modèles, subissent une érosion algorithmique de leur positionnement historique basé sur la notoriété plutôt que sur la performance utilisateur mesurée.

Convergence analytique, vers l’ère de l’intelligence artificielle algorithmique

La synthèse des observations expertes dessine les contours d’une transformation paradigmatique. Cette convergence s’inscrit dans la continuité de l’évolution du SEO sur 30 ans d’histoire et marque potentiellement un tournant majeur dans l’approche algorithmique de Google.

Consensus technique, pivot paradigmatique

L’analyse croisée des sources expertes converge vers trois conclusions majeures :

1. Transition vers l’évaluation IA granulaire : le passage des signaux de ranking traditionels vers l’analyse sémantique section par section (hypothèse MUVERA confirmée par les patterns de récupération)

2. Recalibration sélective post-HCU : les sites ayant maintenu leurs efforts qualité malgré la pénalisation HCU(X) bénéficient d’une réévaluation algorithmique différée

3. Impact cross-surfaces unifié : l’update affecte toutes les interfaces Google (web, images, news, Discover, AI Overviews) via le même core ranking system

Implications stratégiques, adaptation algorithmique

Ces conclusions convergentes redéfinissent les principes fondamentaux d’une stratégie SEO moderne.

Cette convergence analytique dessine les contours d’une nouvelle ère algorithmique où Google évalue l’utilité via des systèmes d’intelligence artificielle capables d’analyse granulaire plutôt que par des signaux proxy traditionnels.

Les sites qui prospèrent dans cette nouvelle donne partagent des caractéristiques communes :

- Architecture informationnelle granulaire qui facilite l’extraction sémantique,

- Expertise de première main documentée plutôt qu’expertise déclarée,

- Anticipation des besoins utilisateur au-delà de la requête immédiate,

- Signaux comportementaux positifs mesurés via NavBoost.

Perspective algorithmique, préparer la prochaine vague

L’analyse prospective de ce Core Update permet d’anticiper les évolutions futures et d’adapter les stratégies SEO en conséquence. Cette anticipation devient essentielle dans un environnement algorithmique en mutation permanente.

Cycle de mise à jour, prédiction automnale

Gabe anticipe logiquement « une autre mise à jour principale, ou deux, à l’automne » basé sur les cycles historiques de déploiement Google. Cette prédiction s’appuie sur l’observation que les ajustements algorithmiques majeurs nécessitent généralement plusieurs itérations pour atteindre leur équilibre optimal.

Pour les sites impactés négativement, la fenêtre de récupération se situe donc aux prochaines mises à jour broad core, ce qui justifie l’approche « kitchen sink » recommandée : identification et correction exhaustive de tous les facteurs qualité dégradés, en s’appuyant sur un guide de tests SEO méthodologique pour valider les améliorations.

Évolution paradigmatique, de l’optimisation à l’utilité

L’enseignement majeur de cette analyse transcende les aspects techniques pour redéfinir l’approche stratégique du SEO.

Le message stratégique émergeant de cette analyse est sans ambiguïté : Google récompense désormais l’utilité authentique mesurée par intelligence artificielle plutôt que l’optimisation technique traditionnelle.

Cette évolution marque potentiellement la fin de l’ère SEO classique basée sur la manipulation de signaux algorithmiques connus, au profit d’une approche centrée sur la création de valeur utilisateur mesurable par des systèmes d’IA de plus en plus sophistiqués.

L’adaptation stratégique requiert donc un pivot fondamental : passer de l’optimisation pour l’algorithme à l’optimisation pour l’intelligence artificielle qui évalue l’utilité réelle du contenu pour les utilisateurs finaux.

Sources : Glenn Gabe, Search Engine Land (Barry Schwartz), Scott Shorter, Marie Haynes, Aleyda Solis (LinkedIn).